Auswege aus der Krise: Zuverlässiges Datenmanagement für Banken und Versicherungen

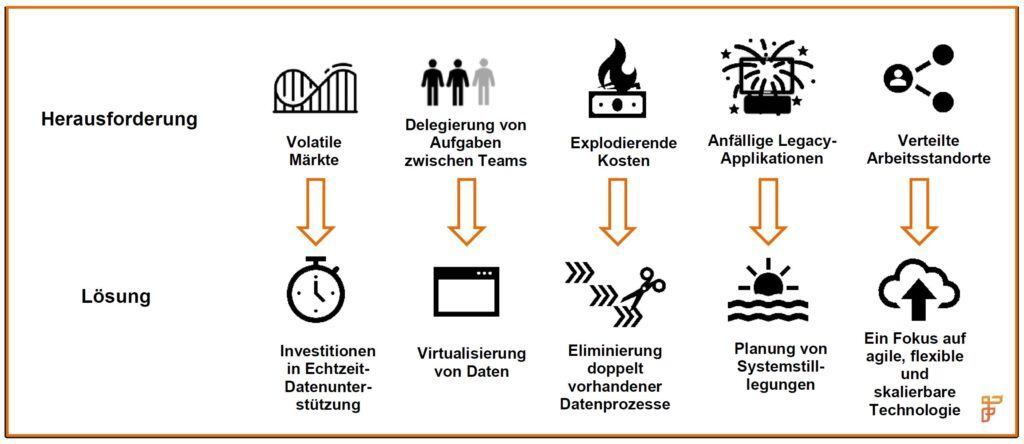

Aktuelle Herausforderungen für Unternehmen

Finanzinstitute agieren derzeit in einem Umfeld, das kein business as usual mehr zulässt. Die Coronakrise hat Ineffizienzen in vielen Unternehmen der internationalen Kapitalmärkte schonungslos aufgedeckt. In den Führungsetagen der großen Konzerne beschäftigt man sich deshalb angesichts zunehmender Handelsvolumen und hoher Volatilität zunehmend mit dem Thema betriebliche Resilienz sowie einem stärkeren Fokus auf Remote-Arbeit.

Die anhaltende Volatilität des Marktes hat trotz des Rezessionsklimas zu einem spürbaren Anstieg des Handelsvolumens geführt – eine Entwicklung, mit der Front-, Middle- und Backoffice-Teams zu kämpfen haben. Zwar sind starke Schwankungen des Kapitalmarkts kein seltenes Phänomen – seit der globalen Finanzkrise 2008 wurden zahlreiche Auf- und Ab-Bewegungen registriert –, dennoch ist die aktuelle gesamtwirtschaftliche Situation in dieser Form einzigartig.

Während vorherige Wirtschaftskrisen der Neuzeit überwiegend ökonomischen Ursprungs waren, stellt die Corona-Pandemie ein externes Ereignis dar, das alle Märkte auf jeweils unterschiedliche Weise trifft. Sowohl globale Player als auch lokale Betriebe sind betroffen und größtenteils zur Remote-Arbeit im Home Office gezwungen.

Die regionale Vielschichtigkeit der Kapitalmärkte bringt ebenfalls einzigartige Herausforderungen mit sich. So lassen sich etwa Homeoffice-Regelungen einfacher in Märkten wie den USA umsetzen, wo Mitarbeiter fast ausnahmslos private Computer oder Laptops besitzen; in Regionen wie Indien hingegen, wo riesige Offshore-Zentren angesiedelt sind, mussten Laptops für die Heimarbeit erst eigens angeschafft und geliefert werden.

Obwohl frühere Krisen zu schwerwiegenden Problemen bei Betriebsabläufen und Datenmanagement geführt haben, ist dennoch kein Markt vor Volatilität gefeit. Viele Firmen waren auf diese Volatilität nicht vorbereitet und konnten Risikoeinschätzungen nicht schnell genug vornehmen, um den neuen Marktbedingungen und den sich verändernden Vermögensklassen gerecht zu werden.

Gerade Unternehmen, für die Batch-Prozesse und End-to-End-Datenübertragung keine Selbstverständlichkeit darstellen, verlieren an Boden gegenüber aufstrebenden agileren Wettbewerbern; ihre Risikobewertungen können mit den dynamischen Marktveränderungen nicht Schritt halten. Die Branche hat sich der zunehmenden Relevanz von Daten nur zögerlich geöffnet. Die aktuellen Umstände erhöhen den Druck auf Unternehmen, Schwächen in ihrer Datenarchitektur zu beseitigen, um optimal für gegenwärtige und zukünftige Herausforderungen gewappnet zu sein.

Ein nahtloser Zugang zu den zahlreichen Datensilos einer globalen Organisation ist unmöglich, wenn keine konsistente, sichere Real-Time-Datenschicht vorhanden ist, über die benötigte Informationen zur rechten Zeit an die zuständigen Entscheidungsträger weitergeleitet werden können. Der universelle Zugriff auf diese Daten ermöglicht es Unternehmen außerdem, akute Herausforderungen zu meistern, die sich aus Homeoffice-Arbeit und immer neuen Anforderungen im Hinblick auf die Geschäftskontinuität ergeben.

Viele Middle- und Back-Office-Systeme lassen Remote-Zugriff bisher nicht ohne Weiteres zu. Eine harmonisierte Datenschicht ist der Schlüssel, um diese Middle- und Backoffice-Funktionen besser zu unterstützen.

Legacy-Umgebungen sind oft nicht darauf ausgelegt, Aufgaben zwischen verschiedenen Personen zu delegieren. Das Key Person Risk, also die Abhängigkeit des Unternehmenserfolgs von einer oder mehreren Schlüsselpersonen, ist hierbei funktionsübergreifend besonders hoch. Da Daten nicht systemweit zugänglich sind, tun sich Manager schwer, einen genauen Überblick über die Marktlage und Geschäftschancen zu erlangen, die sich aus aktuellen Entwicklungen auf Kundenseite und im Marktgeschehen ergeben. Eine Risikobewertung, die nur am Ende eines Geschäftstages erfolgt, kann niemals wirklich zuverlässig sein in einem Marktklima, das sich durch rasante Entwicklungen und Unvorhersehbarkeit auszeichnet. Folglich haben sich die Kalkulation von untertägigen Gewinnspannen (Intraday Margins) und die Bewertung von Anlageklassen zu echten Herausforderungen entwickelt.

[callout_box width="80%" align="center"]

“Die Kapitalmärkte zahlen jetzt den Preis dafür, dass sie wesentliche Investitionen in ihre Datenarchitekturen lange Zeit vernachlässigt haben. Angesichts der aktuellen Marktentwicklung laufen sie Gefahr, den Anschluss zu verpassen.”

[/callout_box]

Marktsegmente, die sich bei der Kundenbetreuung bisher auf persönliche Interaktion konzentriert haben – etwa im Bereich der Finanzberatung –, tun sich schwer, der neuen Lage gerecht zu werden.

Kundeninteraktion, die online oder virtuell erfolgt, kann hingegen besser mit brandaktuellen Datenanalysen und Cloudtechnologien unterstützt werden.

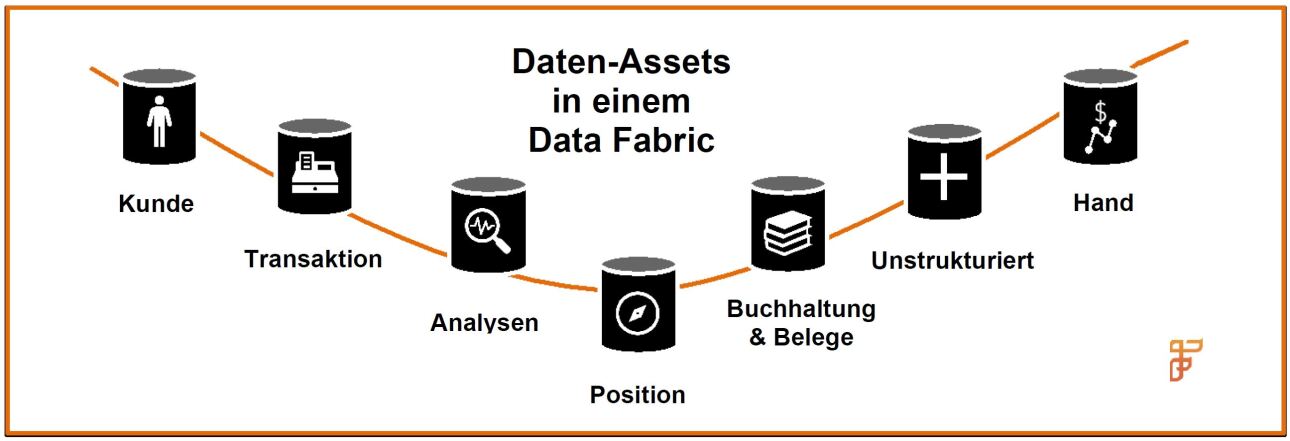

Die Akteure des Kapitalmarkts zählen beim Umstieg auf cloudfähige oder cloudgehostete Umgebungen nicht unbedingt zu den Vorreitern. Viele Prozesse in Kernbereichen des Handelszyklus erfolgen noch immer manuell statt digital. Die Inkompatibilität neu eingeführter Next-Generation-Plattformen mit verbliebenen Legacy-Technologien hat das Problem der einheitlichen Datenhandhabung noch einmal verschärft. Dass der Austausch veralteter Applikationen eine Menge Zeit und Personal in Anspruch nimmt, sollte Firmen aber keinesfalls abschrecken. Denn auch wenn Datensilos auf absehbare Zeit fortbestehen werden, kann die Investition in moderne Datenmanagementtechnologien wie ein Enterprise Data Fabric ermöglichen und dazu beitragen, unternehmensweit verstreute Daten stärker zu vernetzen und in Echtzeit Analyseerkenntnisse aus Daten zu ziehen.

Im Dezember 2019 veröffentlichte die britische Finanzaufsichtsbehörde FCA ein Diskussionspapier, in dem sie eine notwendige Stärkung der betrieblichen Resilienz von Finanzinstituten anmahnte. 1Es handelt sich dabei um die erste Regulierungsstelle von globalem Rang, die eine derartige Initiative in Angriff nahm.

Zweifellos wird sie aber nicht die letzte sein – schließlich hat das Jahr 2020 perfekten Anschauungsunterricht geliefert, wie gut die Branche tatsächlich auf eine Krise vorbereitet ist. Unternehmen müssen jetzt die nötigen Prozesse einleiten, um einer solchen regulatorischen Prüfung standhalten zu können. Die Einhaltung von SLAs und die Minimierung des Risikos von Geschäftsunterbrechungen sind deshalb für Kapitalmarktakteure im Angesicht der Krise sowie mit Blick auf die Zukunft unerlässlich. Um auch zukünftig nicht auf dem Radar der Aufsichtsbehörden aufzutauchen, sollte man mit Blick auf Risikomanagement, Stresstests und analytischen Fähigkeiten gut aufgestellt sein. Die Voraussetzung dafür ist ein robustes Datengerüst.

Das Fundament für Wandel

Die genannten Herausforderungen bereiten dem Senior Management und der C-Suite von Unternehmen im aktuellen Geschäftsklima enormes Kopfzerbrechen. Abgesehen davon, wie aufreibend die derzeitige Krise zweifellos ist – sie bietet durchaus auch einige Chancen. Unternehmen können sich in einem umkämpften Markt von der Konkurrenz abheben, indem sie jetzt Schlüsselinvestitionen tätigen, die akute betriebliche Risiken eindämmen und den Grundstein für nachhaltiges Wachstum und ein rundum digitalisiertes Unternehmen legen. Schwierigkeiten, die die aktuelle Krise mit sich bringt, sollten durch eine ehrliche Einschätzung der technologischen Leistungsfähigkeit angegangen und durch gezielte Investitionen in Kernbereiche gemindert werden.

Im vergangenen Jahrzehnt haben wir einen technologischen Wandel ungeahnten Ausmaßes erlebt. Inzwischen haben Technologien Marktreife erlangt, die präzise, harmonisierte Informationen aus allen Bereichen des Unternehmens an Entscheidungsträger weiterleiten – und das zu jedem gewünschten Zeitpunkt und in Echtzeit. Diese Technologien, darunter auch intelligente Enterprise Data Fabrics, unterstützen Unternehmen dabei, das Potenzial ihrer bestehenden Datenarchitektur besser auszuschöpfen, indem sich bereits vorhandene Applikationen und Daten weiternutzen lassen. Daten werden im laufenden Betrieb on demand abgerufen, integriert, harmonisiert und analysiert, um so eine Vielzahl von Geschäftsinitiativen zu unterstützen. Darüber hinaus sind die Technologien dynamisch skalierbar, um auch in Zeiten der Krise Spitzenlasten bewältigen zu können.

Noch vor fünf Jahren waren Data Lakes in aller Munde. Damals beschäftigten sich viele Datenteams mit derartigen Systemen, um einen besseren Einblick in Geschäftsprozesse zu erhalten und neue, datengestützte Services bereitzustellen.

In der Realität jedoch entpuppten sich viele dieser Datenreservoirs als "data swamps" (= Datensümpfe). Daten wurden ohne weitsichtige Strategie in die Architekturen eingepflegt, wodurch es sich als schwierig erwies, sie in verwertbare Informationen zu verwandeln, die etwa zur Kundenakquise oder für Marktanalysen genutzt werden konnten.

Ein häufiger Use Case für Unternehmen, die bereits einen eigenen Data Lake aufgebaut und mit Daten befüllt haben, ist die Implementierung eines modernen Data Fabrics. Dieses sitzt zwischen Geschäftsseite und bestehendem Data Lake und erleichtert die Umwandlung von Daten und der zugehörigen Metadaten in Informationen, die geschäftlich nutzbar sind. Eine weitere Option für Firmen, die aktuell den Aufbau einer solchen Architektur in Erwägung ziehen, ist die Implementierung eines „smarten“ Data Lake – und der „Smart“-Aspekt macht hier den Unterschied aus. Denn ein smarter Data Lake liefert die unverzichtbare Metadaten-Schicht, mit der Rohdaten ähnlich wie bei einem Data Fabric in verwertbare Geschäftserkenntnisse umgewandelt werden.

Bei der strategischen Prüfung der bestehenden Technologieumgebung für Front-, Middle- und Backoffice sollten folgende Schwerpunkte gesetzt werden: Eliminierung doppelt vorhandener Prozesse; Erhöhung der Effizienz; und auf lange Sicht die Stilllegung veralteter Systeme. Weiterhin sollte eine Dateninfrastruktur etabliert werden, die es Front-Office und Risikomanagement erlauben, unmittelbar auf neue Marktentwicklungen zu reagieren. Und nicht zuletzt sollte im Hinblick auf die Zunahme von Remote Work ein stärkerer Fokus auf Technologien gelegt werden, die nicht an bestimmte Plattformen oder Clouddienste gebunden sind und flexible, agile und skalierbare Formen der Arbeit ermöglichen.

Früher oder später wird sich ein Großteil aller Firmen mit dem Austausch ihrer Legacy-Technologie beschäftigen müssen. Dieser Prozess nimmt jedoch einige Zeit in Anspruch. In der Übergangsphase wird daher eine Datenunterstützung benötigt, damit die Informationen aus Legacy- und Next-Generation-Systemen weiterhin zugänglich und für die geschäftliche Nutzung harmonisiert sind. Dass Datensilos auf Dauer komplett verschwinden, wird wohl Wunschtraum bleiben – funktionsspezifische Applikationen und M&A-Geschäfte, die für Kapitalmarktfirmen charakteristisch sind, bringen in der Regel weitere Datensilos und Integrationsschwierigkeiten mit sich. Ein Data Fabric kann die Reibung beseitigen, der sich manche Geschäftszweige ausgesetzt sehen, wenn Informationen aus verschiedenen Systemen und Funktionen abgerufen werden müssen.

[callout_box width="80%" align="center"]

“Durch die Investition in ein Data Fabric beseitigen Unternehmen Limitationen, die beim Zugriff auf Daten erzeugt werden. Auf diese Weise können sie die Kosten und Komplexität der Datenverarbeitung senken und Erkenntnisse gewinnen, die ihnen einen wertvollen Wettbewerbsvorteil verschaffen.”

[/callout_box]

Eine Investition in ein intelligentes, verteiltes Enterprise Data Fabric bringt für das Business vielfältige Vorteile mit sich. So können sowohl intern als auch extern in kürzester Zeit wertvolle Erkenntnisse gewonnen werden:

- Unternehmen und Endkunden können dank der konsistenten, integrierten und harmonisierten Datenschicht kontinuierlich neue Erkenntnisse geboten werden – mittels beliebiger Skalierung gelingt dies auch bei starker Auslastung.

- Die Technologiegeneration der Zukunft ist auf eine robuste Datengrundlage angewiesen. Künstliche Intelligenz und Machine Learning erfordern eine enorme Menge an aktuellen, bereinigten und normalisierten Daten aus den diversen Unternehmenssilos. Ein Data Fabric stellt diese Daten bereit, ohne dass dafür sämtliche Datenspeicher des Unternehmens von Grund auf neu aufgebaut werden müssten.

- Unternehmen sind in der Lage, Anfragen von Aufsichtsbehörden zeitnah zu beantworten und Compliance-Verstößen aus dem Weg zu gehen. Finanzinstitute können es sich nicht erlauben, ihren Ruf in einer Zeit aufs Spiel zu setzen, in der Auditoren die Datenqualität der Berichterstattung kritisch beobachten und betriebliche Abläufe und Kontrollmechanismen von Firmen genauestens prüfen. Ein Data Fabric liefert die Flexibilität und Performanz, die zur Erfüllung dieser Anforderungen benötigt.

- Dank pünktlich bereitgestellter Risiko- und Analysedaten können Unternehmen in Echtzeit auf Marktentwicklungen reagieren, wovon sowohl das Kapital- als auch das Liquiditätsmanagement Die Entscheidungsfindung in den einzelnen Fachabteilungen wird erleichtert, wenn Firmen bei der Bewertung von Risiken auf aktuelle Informationen zurückgreifen können.

- Wenn interne Teams aufgrund des grassierenden Personalmangels Aufgaben zwischen den Teammitgliedern delegieren müssen, profitieren sie von nahtlosem Datenzugriff. Das Key Person Risk kann reduziert werden, wenn alle Teams über klar geregelte Zugriffsrechte auf die erforderlichen Informationen innerhalb der Organisation zugreifen können.

- Datensicherheit genießt oberste Priorität. Die Zusammenarbeit mit einem verlässlichen Partner in diesem Bereich ist oft eine wesentlich sicherere Option, als selbst zu versuchen, eine Vielzahl verschiedener Open-Source-Tools zu jonglieren – gerade in Anbetracht der zunehmenden Bedeutung, der Cybersicherheit und betrieblicher Resilienz seitens Aufsichtsbehörden und Kunden beigemessen.

- Der Geschäftsbetrieb kann effizienter und effektiver skaliert werden, da marktbedingte Spitzenlasten bei der Datenverarbeitung und Analyseprozessen ausgeglichen werden können. Die Optimierung des Datenerfassungsprozesses geht zudem mit einem geringeren betrieblichen Risiko und einer höheren Resilienz einher.

Ausblick der Zukunft

Langfristig gesehen kann ein Data Fabric zum Katalysator für digitale Transformation werden: Daten lassen sich aus allen Ecken des Unternehmens zusammenführen – insbesondere dank der so wichtigen Metadaten, die eine Bestimmung der Datenherkunft ermöglichen. Anstatt Ressourcen darauf zu verschwenden, die Pünktlichkeit oder Genauigkeit der verschiedenen Datenattribute nachzuvollziehen und einen Prüfpfad für Kunden, Auditoren und interne Teams zu entwerfen, verschafft ein Data Fabric einen Einblick in die zugrundeliegenden Quelldaten und ihre Data Lineage.

Diese Daten können nun in Echtzeit internen und externen Akteuren bereitgestellt werden. Dabei kann es sich um zusätzliche Informationen über Kunden oder Risikodaten für Front-Office-Teams handeln, um die Kosten von Trades abzuschätzen. Bei Marktverschiebungen, wie sie aktuell zu beobachten sind, sind Teams aus den Bereichen Risikomanagement, Collateral Management und Pricing jederzeit Herr der Lage und wissen genau, welche Maßnahmen zu ergreifen sind, um die Liquidität zu sichern und das Wettbewerbs- und Marktrisiko zu minimieren.

Finanzberater können ihren Kunden zu jedem Zeitpunkt die besten Optionen anbieten und laufen nicht Gefahr, von aufstrebenden Marktakteuren verdrängt zu werden. Vermögensverwaltungen wiederum profitieren von hochwertigeren Datenbeständen, die für computer-gestützte Simulationen zur besseren Chancen- und Risikoeinschätzung eingesetzt werden.

Händler erhalten in Echtzeit Zugriff auf verlässliche Daten aus internen Quellen, anstatt darauf warten zu müssen, dass interne Teams Informationen – insbesondere bei weniger liquiden Märkten – validieren und bereinigen.

Werden Daten schneller bereitgestellt, wird auch die Qualität der Entscheidungsfindung angehoben. Mit einem ganzheitlichen Ansatz für auf Silos verteilte Daten erhalten Unternehmen umfangreiche Datenbestände zur Nutzung von Zukunftstechnologien wie Machine Learning (ML), künstlicher Intelligenz (KI) und Natural Language Processing (NLP). Diese Technologien zeichnen sich durch einen großen Datenhunger aus – mit je mehr Informationen die Tools gefüttert werden, desto akkurater sind die Ergebnisse. Gleichzeitig muss die Qualität der Daten, die in eine ML-Plattform eingepflegt werden, hoch sein, was die Bereitstellung präziser, aktueller Daten erfordert.

Beim Vergleich der verfügbaren Marktoptionen sollten die Hardwarekosten und die Komplexität der Lösungsarchitektur sorgfältig geprüft werden. Architekturen, die eine Integration heterogener Stand-alone- Technologien erfordern – etwa ein In-Memory Data Grid mit separatem Datenbankmanagement-System – können mit hohen Kosten, anspruchsvollen Hardwareanforderungen und komplexen Entwicklungs- und Instandhaltungsprozessen einhergehen.

Heute gibt es für Finanzdienstleister andere Möglichkeiten, diese kritischen Geschäftsvorteile mit einer weitaus genügsameren Architektur und wesentlich niedrigeren Gesamtbetriebskosten zu erreichen. Diese Lösungen beinhalten eine zentrale Architektur, die mehrere Schichten und Funktionsbereiche umfasst: eine Kombination eines horizontal skalierbaren Enterprise Data Fabric mit transaktionalem und analytischem Datenbankmanagement plus Integrationsfunktionalität für Rich Data und Applikationslandschaft.

Die neuen Technologien helfen Unternehmen nicht nur, die Nachwirkungen der aktuellen Krise zu bewältigen, sondern weisen auch den Weg in eine digitale Zukunft – ganz ohne kostspieligen Komplettaustausch der vorhandenen betrieblichen Infrastruktur.

Gleich ob ein Unternehmen seine führende Position auf dem Markt behaupten oder Boden gegenüber der Konkurrenz gutmachen will – der zukünftige Geschäftserfolg hängt in hohem Maße von einer robusten Datenarchitektur ab. Wer diese Investition nicht zum rechten Zeitpunkt tätigt, wird auch dann in Schwierigkeiten geraten, wenn auf den Märkten langsam wieder Normalität einkehrt.

Die digitale Transformation eines Unternehmens ist eng an ein solides Datenfundament geknüpft. Beim Blick in die Zukunft sollte bedacht werden, welchen Unterschied diese neuen, nicht-disruptiven, Datentechnologien machen können – bei Kundeninteraktionen, strategischen Analysen sowie für das Risikomanagement und die regulatorische Compliance Ihres Unternehmens. Versorgen Sie Ihre wichtigsten Stakeholder innerhalb und außerhalb des Unternehmens mit kritischen Daten, Insights und Aktionen – on demand und in Echtzeit.

Firebrand Research

Unsere Expertise liegt im Bereich der Marktforschung sowie der Beratung von Unternehmen der globalen Kapitalmärkte. Von Fintech-Investments bis zur Erstellung von Business Cases – wir haben das Know-how, um Ihren Auftrag zu meistern.

- Die Stimme des Marktes

- Unabhängig

- Jahrzehntelange Erfahrung in der Marktforschung

- Praxiserprobt

- Vielfältige Ansätze

- Marktforschung sollte zugänglich sein

Weitere Informationen erhalten Sie unter www.fintechfirebrand.com oder per E-Mail an contact@fintechfirebrand.com

InterSystems

Das 1978 gegründete Unternehmen InterSystems ist der führende Anbieter von Technologie für hochsensible Dateninitiativen im Gesundheitswesen, der Finanzbranche sowie der Fertigungs- und Lieferkettenindustrie – darunter auch Produktivanwendungen bei den meisten der weltweit führenden Banken. Mit seinen „Cloud-first-“Datenplattformen unterstützt es Unternehmen in aller Welt bei der Lösung ihrer Probleme in den Bereichen Skalierbarkeit, Interoperabilität und Geschwindigkeit. InterSystems schreibt Exzellenz groß und bietet seinen Kunden und Partnern in mehr als 80 Ländern preisgekrönten Rund-um-die-Uhr-Support. Das private Unternehmen mit Hauptsitz in Cambridge, Massachusetts (USA) ist mit 25 Niederlassungen rund um den Globus vertreten.

Weitere Informationen erhalten Sie unter InterSystems.com/de/Finanzdienstleistungsbranche

1 “Building operational resilience: impact tolerances for important business services”, FCA, December 2019